一、三大应用场景(优点)

解耦、异步、削峰

- 解耦:只需要将消息写入消息队列,需要消息的去消息队列中订阅就好

- 异步:一些非必要的逻辑可以采用异步来完成,从而提升响应速度

- 削峰:某个时间段并发量特别大的时候可以将消息发送到消息队列中,然后从消息队列中慢慢拉取进行消费

解耦

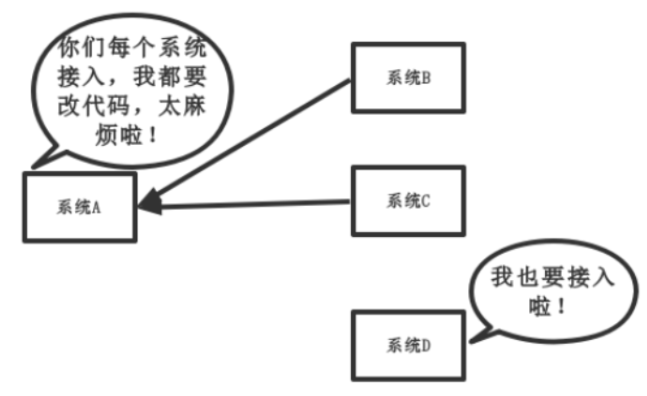

传统模式:

传统模式缺点:

系统间耦合性太强,如上图所示,系统A在代码中直接调用系统B和系统C,如果将来系统D要接入,系统A还要修改代码,过于麻烦!

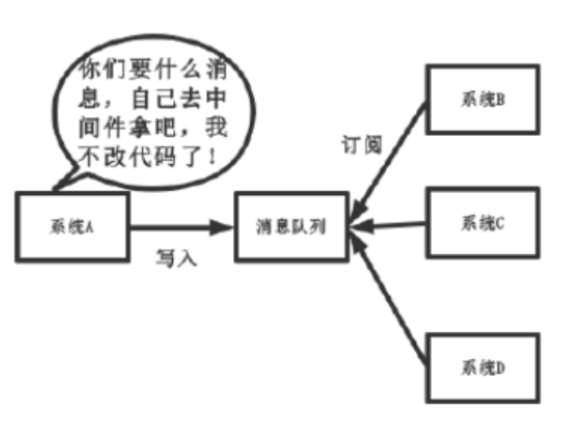

中间件模式优点:

将消息写入消息队列,要消息的系统自己从消息队列中订阅,从而系统A不再需要做任何修改

异步

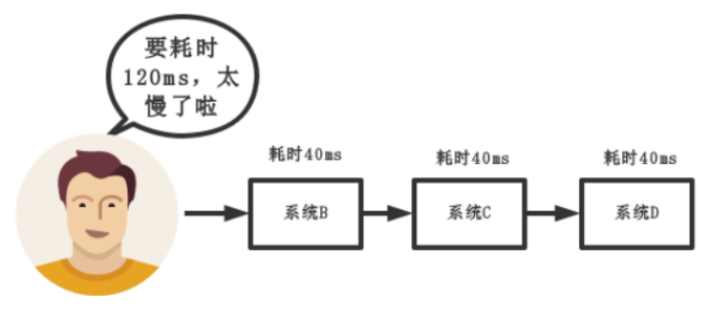

传统模式:

一些非必要的业务逻辑以同步的方式运行,太耗费时间。

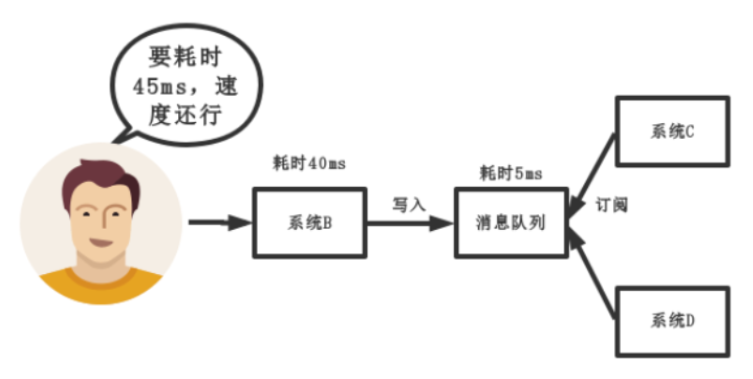

中间件模式:

中间件模式的优点:

将消息写入消息队列,非必要的业务逻辑以异步的方式运行,加快响应速度

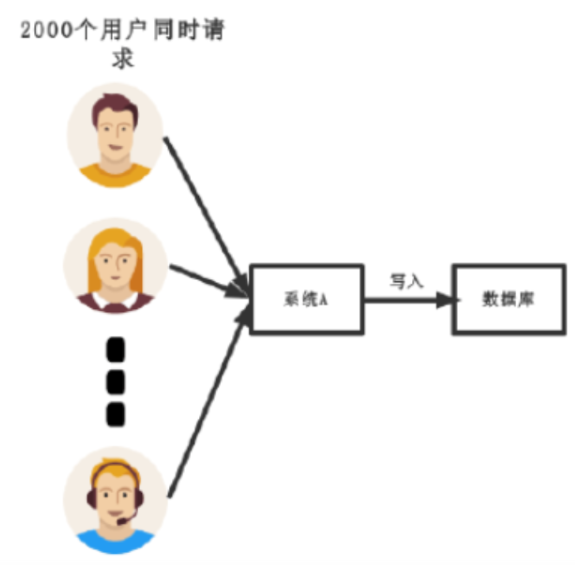

削峰

传统模式:

传统模式缺点:

并发量大的时候,所有的请求直接怼到数据库,造成数据库连接异常

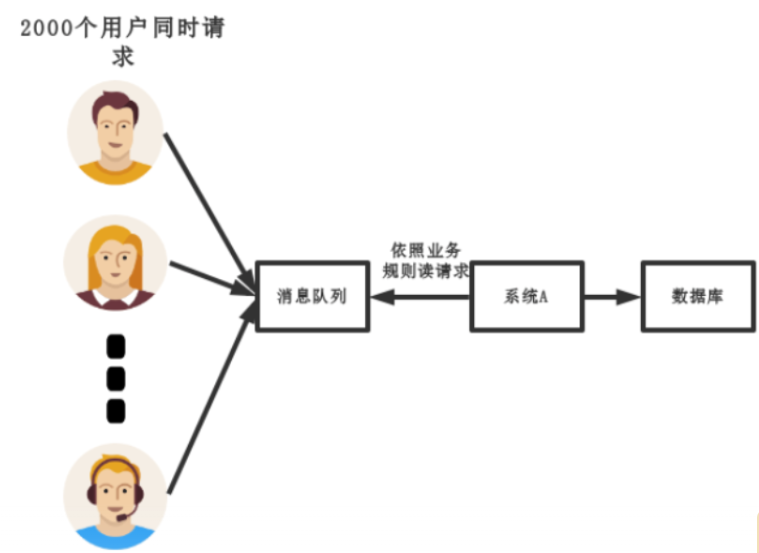

中间件模式:

中间件模式的优点:

系统A慢慢的按照数据库能处理的并发量,从消息队列中慢慢拉取消息。在生产中,这个短暂的高峰期积压是允许的。

二、消息队列的缺点

- 系统可用性降低:如系统原本运行的好好的,加入消息队列后一旦消息队列挂掉,系统直接就over了

- 增加系统的复杂度:采用消息队列后要考虑好多问题,如一致性、如何保证消息不被重复消费、消息的可靠传输

三、消息队列的选型

1、ActiveMQ:更新比较慢、java开发的、万级吞吐量

2、RabbitMQ:相对ActiveMQ来说更新较快、erlang语言开发(erlang语言天生具有高并发的特效,但是熟悉erlang的人相对较少,好在社区比较活跃)

3、RocketMQ:支持分布式架构、Java语言开发可以定制化开发

4、Kafka:支持分布式架构、吞吐量十万级

使用场景:

在我们的电商中,在发送短信和商品上下架的时候使用了rebbitMQ

四、保证消息队列的高可用

分析:在第二点说过了,引入消息队列后,系统可用性下降,在生产中,没人使用单机模式的消息队列,因为作为一个合格的程序员,应该对消息队列的高可用有很深刻的了解。

如果面试时问如何保证高可用?你的回答只是表明自己只会订阅和发布消息,面试官就会怀疑你是不是只是自己搭着玩,没有生产使用过。

以RCOKETMQ为例,它的集群就有多master模式、多master多slave异步复制模式、多master多slave同步双写模式。多master多slave模式部署架构图:

其实博主第一眼看到这个图,就觉得和kafka好像,只是NameServer集群,在kafka中用zookeeper代替,都是用来保存和发现master和slave用的,通信过程如下:

Producer与NameServer集群中的其中一个节点(随机)建立长连接,定期从NameServer获取Topic路由信息,并向提供Topic服务的Broker Master和Slave建立长连接,即可以从Broker Master订阅消息,也可以从Broker Slave订阅消息。

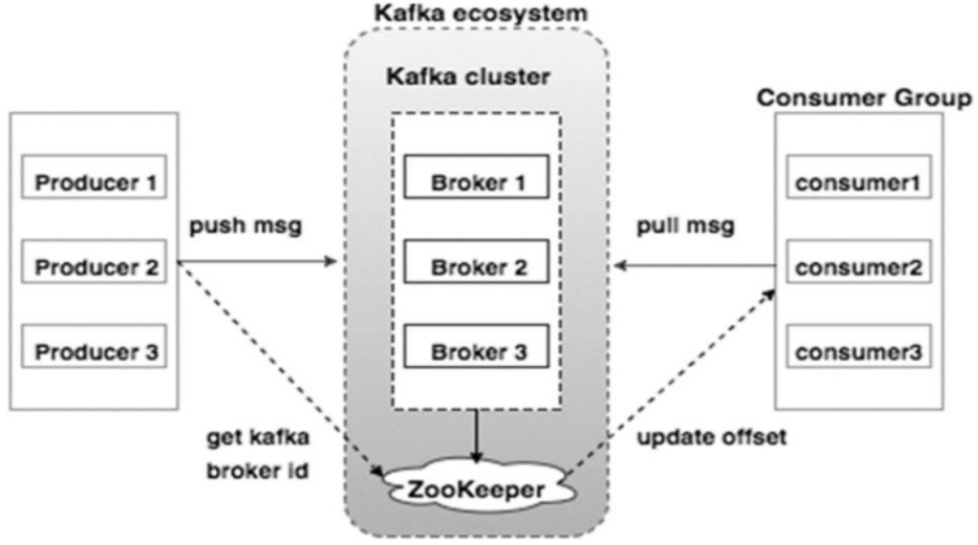

那么kafka呢,为了对比说明直接上kafka拓补结构:

如上图所示,一个典型的Kafka集群中包含若干Producer(可以是web前端产生的page view,或者是服务器日志,系统cpu,memory等),若干broker(Kafka支持水平扩展,一般broker数量越多,集群吞吐率越高),若干Consumer Group,以及一个Zookeeper集群。Kafka通过broker,Consumer使用pull模式从broker订阅并消费消息。

至于rabbitMQ也有普通集群和镜像集群模式,自行去了解,比较简单。

五、如何保证不会重复消费

1、RabbitMQ会发生一个ACK确认消息

2、RocketMQ会返回一个CONSUME_SUCCESS成功标志

3、Kafka每条消息会有一个offset,在消费后需要提交offset,让消息队列知道已经消费

六、如何保证消息的可靠传输

分析:在使用消息队列过程中,应该做到消息不能多消费,也不能少消费。如果无法做到可靠性传输,可能给公司带来千万级别的财产损失。同样的,如果可靠性传输在使用过程中,没有考虑到,这不是给公司挖坑么。还是那句话,认真对待每一个项目,不要给公司挖坑。

三个角度:生产者弄丢数据、消息队列弄丢数据、消费者弄丢数据

RabbitMQ

-

RabbitMQ提供transaction和confirm来保证生产者不丢消息

1.1 transaction机制就是说在发送消息的时候开启事务,然后再发送消息,若发送过程中发生异常则会滚 ,成功则提交 ,缺点就是吞吐量下降

1.2 confirm模式生产上用的居多,一旦channel进入confirm模式,所有在该信道上的消息都会被指派一个唯一ID(从1开始),一旦消息投递到所匹配的队列都,RabbitMQ会发送一个Ack(包含消息的唯一ID)给生产者,这就知道已经消费处理了,如果RabbitMQ没有处理这条消息,则会发送一个Nack消息给你,这就知道消费失败,然后就可以重试了。 -

RabbitMQ消息队列丢数据

2.1 处理消息队列丢数据的情况,一般是开启持久化磁盘的配置。这个持久化配置可以和confirm机制配合使用,你可以在消息持久化磁盘后,再给生产者发送一个Ack信号。这样,如果消息持久化磁盘之前,rabbitMQ阵亡了,那么生产者收不到Ack信号,生产者会自动重发。

2.11 那么如何持久化呢,这里顺便说一下吧,其实也很容易,就下面两步

2.11 1. 将queue的持久化标识durable设置为true,则代表是一个持久的队列

2.11 2. 发送消息的时候将deliveryMode=2

这样设置以后,rabbitMQ就算挂了,重启后也能恢复数据 -

RabbitMQ消费者丢数据

3.1 消费者丢数据一般是因为采用了自动确认消息模式(采用手动提交即可)

Kafka

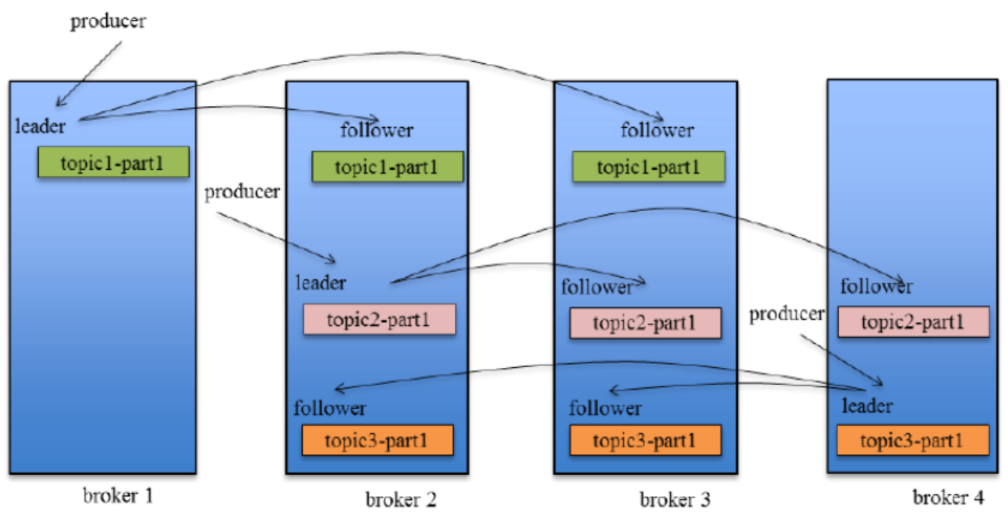

这里先引用一张kafka replication的效果图

Producer在发布消息到某个Partition时,先通过zookeeper找到该partition的leader,然后无论该topic的replication factor为多少(也即该partition有多少个replication),Producer只将该消息发送到该Partition的leader,leader会将该消息写入本地log,每个Follower都从Leader中pull数据。

-

Kafka生产丢失数据

4.1 在kafka生产中,基本都有一个leader和多个follwer。follwer会去同步leader的信息。因此,为了避免生产者丢数据,做如下两点配置

第一个配置要在producer端设置acks=all。这个配置保证了,follwer同步完成后,才认为消息发送成功。

在producer端设置retries=MAX,一旦写入失败,这无限重试 -

Kafka消息队列丢数据

5.1 针对消息队列丢数据的情况,无外乎就是,数据还没同步,leader就挂了,这时zookpeer会将其他的follwer切换为leader,那数据就丢失了。针对这种情况,应该做两个配置。

replication.factor参数,这个值必须大于1,即要求每个partition必须有至少2个副本

min.insync.replicas参数,这个值必须大于1,这个是要求一个leader至少感知到有至少一个follower还跟自己保持联系。这两个配置加上上面生产者的配置联合起来用,基本可确保kafka不丢数据 -

Kafka消费者丢数据

6.1 这种情况一般是自动提交了offset,然后你处理程序过程中挂了。kafka以为你处理好了。解决方案也很简单,改成手动提交即可。

6.2 offset介绍:

6.21 offset:指的是kafka的topic中的每个消费组消费的下标。简单的来说就是一条消息对应一个offset下标,每次消费数据的时候如果提交offset,那么下次消费就会从提交的offset加一那里开始消费。

比如一个topic中有100条数据,我消费了50条并且提交了,那么此时的kafka服务端记录提交的offset就是49(offset从0开始),那么下次消费的时候offset就从50开始消费。

本文章来源于互联网,如有侵权,请联系删除!原文地址:ActiveMQ、RocketMQ、RabbitMQ、Kafka区别